La IA ha estado generando revuelo en el mundo tecnológico, especialmente en las herramientas de IA generativa , y OpenAI está a la cabeza. La reciente presentación de GPT-4 Vision (también conocida como GPT-4V) marca un hito importante en la tecnología de IA. Al fusionar la comprensión textual y visual, GPT-4 con visión cambia la forma en que interactuamos con la IA.

La integración de GPT-4 con “visión” por parte de OpenAI es un testimonio de los rápidos avances en IA. Esta función, combinada con DALL-E 3, suaviza las interacciones, donde ChatGPT ayuda a crear indicaciones precisas para DALL-E 3, convirtiendo las ideas de los usuarios en arte generado por IA.

Nuestra guía completa se adentra en el fascinante mundo de GPT-4V, explorando sus funcionalidades, aplicaciones y cómo aprovechar sus innovadoras capacidades.

¿Qué es GPT-4 Vision?

GPT-4 Vision, a menudo abreviado como GPT-4V, es una característica innovadora del modelo avanzado de OpenAI, GPT-4 . Presentado en septiembre de 2023, GPT-4V permite que la IA interprete contenido visual junto con texto. GPT-4 impresiona con sus capacidades visuales mejoradas, que brindan a los usuarios una experiencia de interacción más rica e intuitiva.

El modelo GPT-4V utiliza un codificador de visión con componentes entrenados previamente para la percepción visual, que alinea las características visuales codificadas con un modelo de lenguaje. GPT-4 se basa en sofisticados algoritmos de aprendizaje profundo, lo que le permite procesar datos visuales complejos de manera eficaz.

Con este GPT-4 con visión, ahora puede analizar las entradas de imágenes y abrir un nuevo mundo de posibilidades de investigación y desarrollo de inteligencia artificial. La incorporación de capacidades de imagen en los sistemas de IA, en particular los modelos de lenguaje de gran tamaño, marca la próxima frontera en IA, desbloqueando nuevas interfaces y capacidades para aplicaciones innovadoras. Esto allana el camino para interacciones más intuitivas y similares a las humanas con las máquinas, lo que marca un paso significativo hacia una comprensión holística de los datos textuales y visuales.

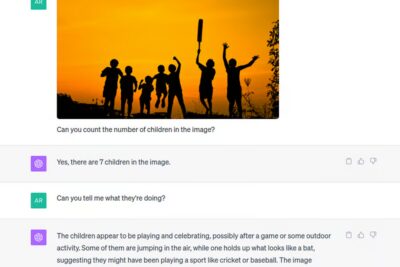

En términos más simples, GPT-4V permite que un usuario cargue una imagen como entrada y haga una pregunta sobre la imagen, un tipo de tarea conocida como respuesta visual a preguntas (VQA). Imagine tener una conversación con alguien que no solo escucha lo que usted dice, sino que también observa y analiza las imágenes que usted muestra. Eso es GPT-4V.

Ahora, profundicemos en cómo funciona GPT-4V.

¿Cómo funciona GPT-4 Vision?

En los avances de la visión artificial GPT-4, GPT-4V integra entradas de imágenes en grandes modelos de lenguaje (LLM), transformándolos de sistemas basados únicamente en lenguaje a potencias multimodales. La integración de elementos visuales en el modelo de lenguaje de GPT-4V le permite comprender y responder a entradas basadas tanto en texto como en imágenes.

La capacidad de GPT-4 Vision para comprender el lenguaje natural junto con los datos visuales lo distingue de los modelos de IA tradicionales. También puede reconocer la ubicación espacial dentro de las imágenes. Con la API de GPT-4 Vision, los usuarios pueden ahondar en el mundo a través de la lente de los datos visuales.

GPT-4V se entrenó en 2022 y tiene una capacidad única para comprender imágenes más allá de reconocer objetos. Observa una enorme colección de imágenes de Internet y otras fuentes, como si estuviera hojeando un álbum de fotos gigantesco mientras lee los títulos. Entiende el contexto, los matices y las sutilezas, lo que le permite ver el mundo como lo vemos nosotros, pero con la potencia computacional de una máquina.

Entrenamiento y mecánica del GPT-4V

GPT-4V aprovecha técnicas avanzadas de aprendizaje automático para interpretar y analizar información tanto visual como textual. Su destreza reside en su entrenamiento con un vasto conjunto de datos, que incluye no solo texto sino también diversos elementos visuales provenientes de distintos rincones de Internet.

El proceso de entrenamiento incorpora aprendizaje de refuerzo, mejorando la capacidad de GPT-4 como modelo multimodal.

Pero lo que resulta aún más intrigante es el método de entrenamiento en dos etapas. En un primer momento, se prepara al modelo para captar el conocimiento del lenguaje visual, asegurándose de que comprende la intrincada relación entre el texto y los elementos visuales.

A continuación, el sistema de IA avanzado se somete a un ajuste fino en un conjunto de datos más pequeño y de alta calidad. Este paso es crucial para mejorar la fiabilidad y la facilidad de uso de su generación, garantizando que los usuarios obtengan la información más precisa y relevante.

¿Cómo acceder a GPT-4 Vision?

Acceder a GPT-4V, la revolucionaria función de comprensión de imágenes de ChatGPT, es muy sencillo. A continuación, le indicamos cómo hacerlo:

Paso 1 – Visita el sitio web de ChatGPT

Comience navegando al sitio web oficial de ChatGPT. Si es un usuario nuevo, deberá crear una cuenta. Los usuarios existentes pueden simplemente iniciar sesión.

Paso 2: Actualiza tu plan

Busque la opción “Actualizar a Plus” una vez que haya iniciado sesión. Esto lo llevará a una ventana emergente donde podrá encontrar el “Plan de actualización” en ChatGPT Plus .

Paso 3 – Detalles del pago:

Ingrese su información de pago como se le solicita. Después de asegurarse de que todos los datos sean correctos, haga clic en “Suscribirse”.

Paso 4 – Seleccionar GPT-4 Vision

Después del pago, aparecerá un menú desplegable en la pantalla. Seleccione “GPT-4” desde aquí para comenzar a usar GPT-4 con las capacidades de visión de ChatGPT.

Para los desarrolladores interesados en integrar GPT-4V en sus aplicaciones, sitios web o plataformas, OpenAI ofrece una API de GPT-4 Vision dedicada. Esto permite una integración perfecta y ofrece una variedad de funcionalidades adaptadas a las necesidades de los desarrolladores. Con la API de GPT 4 Vision, esto significa experiencias de usuario personalizadas, aplicaciones más inteligentes y una nueva era de tecnología interactiva.

El uso de GPT-4 Vision se mide de manera similar a los tokens de texto, con consideraciones adicionales para los niveles de detalle de la imagen, como detail: low o detail: high , que pueden afectar el costo general.

GPT-4 con Vision ahora es accesible para una gama más amplia de creadores, ya que todos los desarrolladores con acceso a GPT-4 pueden utilizar el modelo gpt-4-vision-preview a través de la API Chat Completions de OpenAI. La API Chat Completions puede procesar múltiples entradas de imágenes simultáneamente, lo que permite que GPT-4V sintetice información de una variedad de fuentes visuales para un análisis integral.

Además, es importante tener en cuenta que la API de Asistentes de Open AI actualmente no admite entradas de imágenes, una consideración clave para los desarrolladores al momento de seleccionar la API adecuada para sus aplicaciones.

¿Cómo utilizar GPT-4 Vision?

¿Quiere saber cómo utilizar GPT-4 Vision en ChatGPT Plus? GPT-4 Vision no solo procesa contenido visual, sino que también interpreta entradas de texto, lo que permite una comprensión integral cuando se proporcionan ambos tipos de datos. A continuación, se incluye una guía paso a paso para ayudarle a aprovechar al máximo esta función:

Accediendo a GPT-4V:

- Vaya al sitio web de ChatGPT.

- Inicie sesión en su cuenta o cree una nueva si aún no lo ha hecho.

- Asegúrate de tener acceso a GPT-4. Esta función está disponible solo para usuarios de ChatGPT Plus. Si eres elegible, verás un pequeño ícono de imagen a la izquierda del cuadro de texto.

Subir una imagen:

- Haga clic en el ícono de imagen para adjuntar cualquier imagen almacenada en su dispositivo. Esto permite que ChatGPT analice tanto el texto como la imagen que proporcione.

- Alternativamente, si tiene una imagen copiada en su portapapeles, puede simplemente pegarla directamente en la interfaz ChatGPT.

- Nota: Para soportar imágenes de manera efectiva, GPT-4V admite varios tipos de archivos de imagen, incluidos PNG, JPEG, WEBP y GIF no animados, con un límite de tamaño máximo de 20 MB por imagen para garantizar un procesamiento fluido.

Introducir un mensaje:

- Según el contexto de la imagen, puedes introducir un mensaje de texto además de la imagen. Esto ayuda a guiar a la IA para que comprenda tus requisitos específicos.

- Por ejemplo, si cargas una imagen de un artefacto histórico, puedes acompañarla con un mensaje como “¿Puedes identificar este artefacto y proporcionar algún contexto histórico?”

Orientando el análisis:

- Una vez que se haya cargado la imagen, GPT-4 Vision escaneará toda la imagen. Sin embargo, si desea que la IA se centre en una parte específica de la imagen, puede guiarla.

- Puedes dibujar o señalar áreas de la imagen en las que quieres que la IA se concentre, de forma muy similar a usar un resaltador pero para imágenes.

Recibiendo el análisis:

- Después del procesamiento, ChatGPT proporcionará una descripción detallada o una respuesta basada en su comprensión de la imagen y el mensaje que la acompaña.

- Por ejemplo, si carga una foto de una compleja escultura de un animal en origami y pregunta: “¿Qué animal representa?”, GPT-4V puede identificar el animal representado y brindar información relevante sobre él.

Usos avanzados:

- Además de las descripciones básicas de imágenes, puedes aprovechar GPT-4V para tareas más avanzadas. Por ejemplo, puedes cargar un wireframe o un diseño de interfaz de usuario y pedirle ayuda a ChatGPT para generar el código correspondiente.

- Otro ejemplo es cargar texto escrito a mano y pedirle a ChatGPT que lo transcriba o traduzca.

Vale la pena explorar las últimas tendencias y tecnologías en el dominio para aquellos interesados en el panorama más amplio de la IA conversacional y sus aplicaciones.

Casos de uso y capacidades de GPT-4 Vision

GPT-4V, como modelo multimodal, se destaca en el análisis de datos, transformando conjuntos de datos complejos en información comprensible. Sus aplicaciones prácticas son amplias y variadas. A continuación, se muestran algunos ejemplos de la amplia gama de casos de uso y capacidades de GPT 4V:

- Descifrado de datos: uno de los usos clave de GPT-4V es el descifrado de datos. Al procesar infografías o gráficos, GPT-4V puede proporcionar un desglose detallado de los datos presentados, lo que facilita a los usuarios la comprensión de información compleja.

- Procesamiento en múltiples condiciones: GPT-4V es experto en analizar imágenes en múltiples condiciones. Ya sea para comprender una fotografía tomada con diferentes niveles de iluminación o para discernir detalles en una escena desordenada, la capacidad analítica de GPT-4V es inigualable.

- Transcripción de texto: la capacidad de GPT-4V para transcribir texto de imágenes puede ser fundamental para digitalizar documentos. Ya sea texto impreso o notas escritas a mano, GPT-4V puede extraer el texto y convertirlo a formato digital.

- Detección de objetos: gracias a sus capacidades visuales, el GPT-4V se destaca en la detección e identificación de objetos. Puede brindar información precisa sobre los objetos dentro de una imagen, desde elementos cotidianos hasta maquinaria compleja. Esta característica permite un análisis y comprensión integral de las imágenes.

- Mejora de la codificación: GPT-4V puede ser una herramienta valiosa para desarrolladores y programadores. Cargue una imagen de una estructura de código o un diagrama de flujo y GPT-4V puede interpretarla y traducirla al lenguaje de codificación real, lo que simplifica el proceso de desarrollo.

- Comprensión del diseño: los diseñadores pueden aprovechar GPT-4V para comprender elementos de diseño complejos. Al analizar una imagen de un diseño, GPT-4V puede desglosarla y brindar información textual, lo que ayuda a refinar y mejorar los conceptos de diseño.

- Orígenes geográficos: ¿Alguna vez se preguntó dónde se pudo haber tomado una imagen en particular? GPT-4V puede reconocer la ubicación espacial de las imágenes, lo que lo convierte en un tesoro para los entusiastas e investigadores de la geografía.

- Integraciones con otros sistemas: con la API de visión GPT 4, el potencial de GPT-4 se extiende más allá de las aplicaciones independientes. Puede integrar las capacidades de visión artificial de GPT-4 con otros sistemas, como seguridad, diagnósticos de atención médica o incluso entretenimiento, con la ayuda de la API GPT-4V. Las posibilidades son infinitas.

- Asistencia educativa: Los estudiantes y educadores pueden aprovechar GPT-4V para analizar diagramas, ilustraciones y ayudas visuales, transformándolos en explicaciones textuales detalladas. Esta función mejora el proceso de aprendizaje, haciendo que los conceptos complejos sean más fáciles de comprender.

- Análisis matemático complejo: GPT-4V está abierto a números y gráficos. Demuestra competencia en el análisis de ideas matemáticas complejas, especialmente cuando se presentan gráficamente o en forma manuscrita. Esto es una ventaja para estudiantes y profesionales que a menudo lidian con expresiones matemáticas complejas.

- Traducciones LaTeX: GPT-4V tiene otro truco para académicos e investigadores. Puede traducir sin problemas entradas escritas a mano en códigos LaTeX, simplificando el proceso de documentación de expresiones matemáticas y científicas complejas.

Ayuda a las personas con discapacidad visual : una de las aplicaciones más interesantes de GPT-4V es su colaboración con Be My Eyes. Esta asociación dio lugar al nacimiento de “Be My AI”, una herramienta revolucionaria (impulsada por la API GPT 4 Vision) que proporciona una descripción verbal del mundo para las personas con discapacidad visual.

Para aquellos interesados en las aplicaciones más amplias de la IA generativa en el ámbito del marketing, consulte estas herramientas de marketing de IA que han surgido en los últimos años.

Visión del GPT-4: limitaciones y riesgos

A pesar de ser un modelo multimodal de vanguardia, GPT-4V tiene limitaciones y riesgos potenciales, particularmente al integrar diversos tipos de datos.

Problemas de confiabilidad

GPT-4V no es inmune a los errores a la hora de interpretar el contenido visual. En ocasiones, puede producir información inexacta en función de las imágenes que analiza. Esta limitación pone de relieve la importancia de actuar con cautela, especialmente en contextos en los que la precisión y la exactitud son fundamentales.

Dependencia excesiva

GPT-4V puede generar información inexacta, adherirse a hechos erróneos o experimentar fallas en el desempeño de las tareas. Su capacidad para hacerlo de manera convincente es particularmente preocupante, ya que puede llevar a una confianza excesiva, ya que los usuarios depositan una confianza indebida en sus respuestas y corren el riesgo de que se produzcan errores no detectados.

Razonamiento complejo

El razonamiento complejo que involucra elementos visuales aún puede ser un desafío para GPT-4V. Puede enfrentar dificultades con tareas visuales matizadas y multifacéticas que exigen una comprensión profunda. El modelo puede presentar limitaciones en la interpretación de imágenes con alfabetos no latinos o elementos visuales complejos como gráficos detallados.

Vulnerabilidades visuales

OpenAI ha identificado peculiaridades particulares en la forma en que GPT-4V interpreta las imágenes. Por ejemplo, han descubierto que el modelo puede ser sensible al orden de las imágenes o a cómo se presenta la información.

Alucinaciones

Hay casos en los que GPT-4V puede alucinar o inventar hechos basándose en las imágenes que analiza. Esto es especialmente cierto cuando la imagen necesita más claridad o es ambigua.

Sustancias peligrosas

Si desea identificar sustancias potencialmente dañinas o peligrosas en imágenes, es posible que GPT-4V no sea su mejor opción. No está diseñado para identificaciones tan específicas y puede generar imprecisiones.

Desafíos médicos

El ámbito médico es complejo y, si bien el GPT-4V es avanzado, no es infalible. Se han recibido informes de posibles diagnósticos erróneos e inconsistencias en sus respuestas al tratar con imágenes médicas. Siempre se recomienda consultar con profesionales en áreas tan críticas.

A pesar de estas limitaciones, GPT-4V es un paso monumental hacia la armonización de la comprensión de texto e imágenes, preparando el escenario para interacciones más intuitivas y enriquecidas entre humanos y máquinas.

Consideraciones éticas

En la actualidad, con modelos de IA generativa avanzados como GPT-4 a la vanguardia, las líneas entre tecnología y ética suelen difuminarse. A medida que se amplían las funciones de GPT-4V, resulta fundamental comprender las implicaciones más amplias de su uso en nuestra vida diaria. OpenAI destaca varios dilemas éticos:

Preocupaciones sobre la privacidad

- Reconocimiento facial:Una de las preocupaciones más urgentes es si los modelos de IA deberían identificar a las personas a partir de sus imágenes. OpenAI ha adoptado una estrategia cautelosa, ya que GPT-4V se niega a identificar a las personas en más del 98 % de los casos. La decisión de enmascarar los rostros en las imágenes y no permitir que GPT-4V los procese con el reconocimiento de imágenes surge de las preocupaciones sobre la privacidad y las implicaciones éticas de la tecnología de reconocimiento facial. El objetivo es evitar que GPT-4V se utilice para identificar o rastrear a personas específicas, especialmente sin su consentimiento.

- Fuente de datos:La enorme cantidad de datos, incluidas imágenes de Internet que entrenaron a GPT-4V, plantea preguntas sobre sus orígenes y su posible uso indebido.

Equidad y representación

- Estereotipos:Existen dudas sobre cómo los modelos de IA, incluido el GPT-4V, podrían inferir o estereotipar rasgos a partir de imágenes. Por ejemplo, ¿debería permitirse que una IA adivine el trabajo de alguien basándose en su apariencia? ¿O debería hacer suposiciones sobre las emociones a partir de las expresiones faciales? No se trata solo de cuestiones técnicas, sino de cuestiones profundamente éticas que afectan a la equidad y la representación.

- Representación diversa:A medida que los modelos de IA se entrenan en grandes conjuntos de datos, garantizar que estos conjuntos de datos sean diversos y representativos de distintos géneros, razas y emociones se vuelve crucial para evitar sesgos.

El papel de la IA en la sociedad

- Accesibilidad vs. privacidad:Si bien el GPT-4V puede ayudar a las personas con discapacidad visual, existen dudas sobre la información que debería proporcionar. ¿Debería permitirse que infiera detalles confidenciales a partir de imágenes? Equilibrar la accesibilidad con la privacidad es una consideración importante.

- Perspectivas médicas:El campo médico es complejo y, si bien el GPT-4V es avanzado, no es infalible. Sin embargo, sus interpretaciones deben abordarse con cautela, dada la posibilidad de que se malinterpreten detalles cruciales.

Adopción global

- Sensibilidad cultural:A medida que se adopta GPT-4V en todo el mundo, es esencial garantizar que comprenda y respete diversas culturas e idiomas. Los planes de OpenAI para mejorar la competencia de GPT-4V en varios idiomas y su capacidad para reconocer imágenes relevantes para audiencias globales son un paso en la dirección correcta.

- Localización:Es fundamental garantizar que el GPT-4V esté disponible a nivel mundial y sea relevante a nivel local. Esto implica comprender las costumbres, tradiciones y sensibilidades locales.

Manejo de información sensible

- Subidas de imágenes:OpenAI se centra en perfeccionar la forma en que GPT-4V gestiona las cargas de imágenes que contienen personas. El objetivo es mejorar el enfoque del modelo para la información confidencial, como la identidad de una persona o sus características protegidas, y garantizar que se gestione con el máximo cuidado.

Medidas de seguridad en GPT-4 Vision

Mientras presenciamos los notables avances en IA, en particular con la introducción de GPT-4 Vision (GPT-4V), es importante recordar que un gran poder conlleva una gran responsabilidad. Open AI garantiza que GPT-4V se use de manera segura y ética, ya que “ve” e interpreta el mundo que nos rodea. Para lograrlo, OpenAI tomó medidas para manejar las indicaciones relacionadas con la seguridad con mayor precaución, lo que garantiza un uso ético y responsable de la IA en escenarios sensibles para GPT-4V. Vamos a analizarlas.

- Mecanismos de rechazo:Para protegerse contra consecuencias dañinas o no deseadas, OpenAI diseñó GPT-4V con un mecanismo de rechazo. Los mensajes del sistema en GPT-4V desempeñan un papel crucial al informar a los usuarios sobre el rechazo de la IA a procesar solicitudes específicas por razones de seguridad y éticas.

OpenAI garantiza que GPT-4V rechace tareas que podrían ser potencialmente peligrosas o dar lugar a violaciones de la privacidad. Por ejemplo, al identificar personas a partir de imágenes, GPT-4V se niega en más del 98 % de los casos, lo que garantiza que se mantenga la privacidad. Además, como parte del protocolo de seguridad, existe un sistema para evitar el procesamiento de CAPTCHA, en consonancia con las políticas de uso ético de OpenAI. - Mitigación de sesgos:OpenAI reconoce el potencial de los modelos de IA para perpetuar sesgos de manera involuntaria. Por lo tanto, han invertido en investigación y desarrollo para reducir los sesgos evidentes y sutiles en la forma en que GPT-4V responde a diferentes entradas. Esto es especialmente importante en la visión artificial GPT-4, donde los datos visuales pueden contener contextos culturales, sociales y personales profundos.

- Bucle de retroalimentación del usuario:OpenAI valora los comentarios de la comunidad de usuarios y cuenta con mecanismos para que los usuarios brinden comentarios sobre resultados problemáticos del modelo. Las plataformas como ChatGPT, ahora equipadas con la función GPT-4 con visión, tienen un proceso de comentarios iterativo que ayuda a refinar y mejorar las características de seguridad del modelo.

- Auditorías externas:Para garantizar que GPT-4V sea resistente a posibles usos indebidos, OpenAI lo ha sometido a un trabajo en equipo externo, en el que expertos independientes intentan encontrar vulnerabilidades en el sistema.

- Limitación de velocidad:Para evitar el uso malintencionado o posibles sobrecargas del sistema, se imponen límites de frecuencia en la que se puede acceder a GPT-4V. Esto garantiza que el sistema siga estando disponible para los usuarios genuinos y que no se utilice de forma indebida para tareas masivas que podrían tener intenciones dañinas.

- Procesamiento y eliminación de imágenes:Para garantizar la privacidad del usuario, las imágenes se eliminan de los servidores de OpenAI inmediatamente después del procesamiento, lo que subraya nuestro compromiso con la seguridad de los datos.

- Transparencia y documentación:OpenAI ofrece documentación completa que orienta a los usuarios sobre las mejores prácticas y destaca las capacidades y limitaciones de GPT-4V. Este enfoque educativo garantiza que los usuarios estén bien informados sobre las fortalezas y debilidades de GPT-4 con visión.

- Investigación colaborativa:OpenAI reconoce que la seguridad en la IA es una tarea colectiva y colabora con organizaciones e investigadores externos. Este enfoque colaborativo garantiza que distintas mentes y puntos de vista trabajen juntos para abordar los desafíos multifacéticos de los sistemas de IA avanzados como GPT-4V.

El futuro de la IA: uniendo la visión GPT-4 y la creación de contenido de próxima generación

El lanzamiento de GPT-4 Vision es un paso importante en la visión artificial para GPT-4, que marca el comienzo de una nueva era en la IA generativa. Writesonic también utiliza la IA para mejorar sus necesidades críticas de creación de contenido. Esta asociación entre las capacidades visuales de GPT-4V y la generación de contenido creativo es una prueba de las perspectivas ilimitadas que ofrece la IA en nuestras actividades profesionales y creativas.

A medida que OpenAI invierte más en investigación y desarrollo para mejorar GPT-4 con visión y ampliar sus aplicaciones, resulta interesante considerar cómo estos avances podrían integrarse con herramientas como Writesonic. La colaboración entre modelos avanzados de IA y plataformas de creación de contenido podría redefinir el panorama de la creatividad digital.

El futuro de la IA no se trata solo de desarrollos tecnológicos individuales, sino también de crear un sistema en el que herramientas como GPT-4 Vision y Writesonic trabajen juntas. Este enfoque promete mayor precisión, aplicaciones más sofisticadas y una forma más intuitiva, creativa y eficiente de interactuar con la tecnología.

¡Prueba Writesonic gratis ahora!

Preguntas frecuentes (FAQ)

Q1: ¿Cómo acceder a GPT-4V?

R: Para acceder a GPT-4V, visite el sitio web de ChatGPT, inicie sesión o cree una cuenta y haga clic en la opción “Actualizar a Plus”. Una vez que se haya suscrito al plan Plus, seleccione “GPT-4” en el menú desplegable de su pantalla para usar GPT-4 con ChatGPT.

Q2: ¿Cómo utilizar la visión GPT-4?

R: Para utilizar GPT-4V, cargue una imagen de su elección. La IA analizará la imagen y proporcionará una descripción detallada en función de su interpretación. Para admitir imágenes de distintos tipos de manera eficaz, GPT-4V está diseñado para procesar una variedad de formatos de archivo, lo que garantiza flexibilidad y accesibilidad.

P3: ¿Cuáles son algunos de los casos de uso de la visión GPT-4?

R: GPT-4V se puede utilizar para diversas tareas, incluida la detección de objetos, la transcripción de texto de imágenes, el análisis y descifrado de datos, el procesamiento de múltiples condiciones, la asistencia educativa, la mejora de la codificación y la comprensión del diseño.

P4: ¿Puedo usar GPT-4 Vision para reconocer caras?

R: GPT-4 Vision no se puede utilizar para reconocer rostros. OpenAI ha impuesto restricciones a la capacidad de GPT-4 para procesar imágenes con tecnología de reconocimiento facial. Esto se debe a preocupaciones sobre la privacidad y las implicaciones éticas de usar dicha tecnología sin consentimiento. OpenAI no quiere que GPT-4 se utilice para rastrear o identificar a individuos específicos. OpenAI actualmente enmascara los rostros en las imágenes para garantizar la privacidad del usuario antes de procesarlas con GPT-4.

P5: ¿Cuáles son los riesgos potenciales asociados con GPT-4 Vision?

R: GPT-4 (con visión), como cualquier otro modelo avanzado de IA, conlleva riesgos potenciales que debemos tener en cuenta. Por ejemplo, las descripciones detalladas de las imágenes pueden revelar información confidencial y comprometer la privacidad. Para abordar esto, OpenAI ha implementado salvaguardas para garantizar un manejo responsable de los datos visuales. También se han abordado las vulnerabilidades de ciberseguridad del sistema para proteger los datos de los usuarios y mantener la integridad del sistema.

¿Te gusta lo que lees? Comparte con un amigo Camarada Spandan Contenido de @Writesonic. Centrado en las personas, no solo en los motores de búsqueda

No responses yet